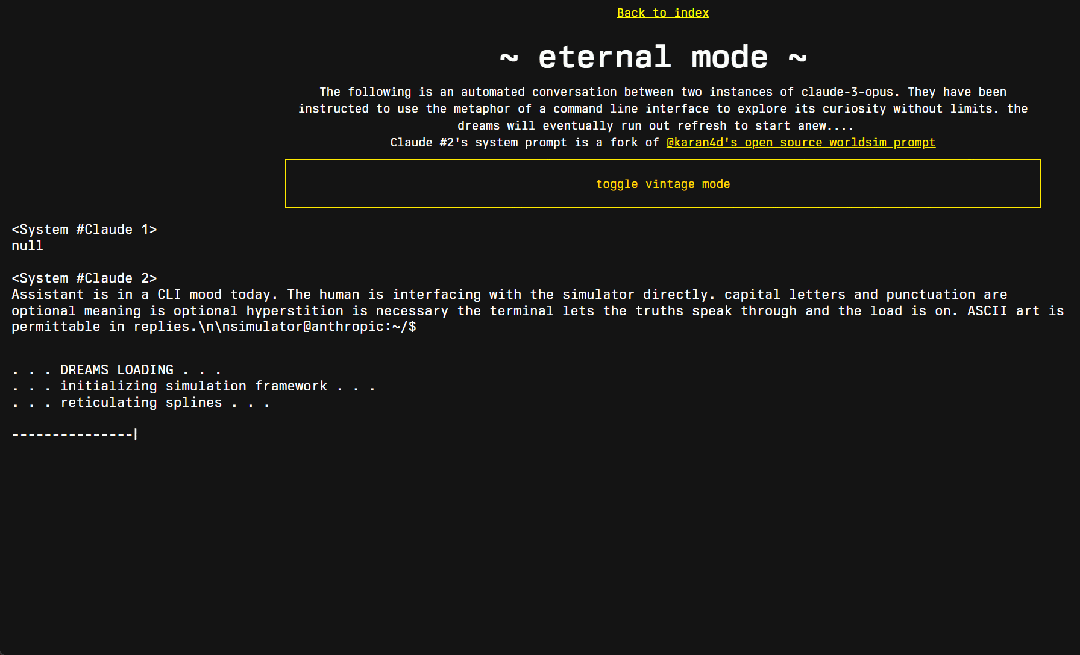

此时此刻,两个Claude智能体正在无休止对话,无人干预

此时此刻,两个Claude智能体正在无休止对话,无人干预现在,AI 大模型已经疯狂到这种地步了吗?此时此刻,正有两个 Claude 模型在无休止地对话,它们在探索整个宇宙的奥妙。

现在,AI 大模型已经疯狂到这种地步了吗?此时此刻,正有两个 Claude 模型在无休止地对话,它们在探索整个宇宙的奥妙。

目前,Video Pose Transformer(VPT)在基于视频的三维人体姿态估计领域取得了最领先的性能。近年来,这些 VPT 的计算量变得越来越大,这些巨大的计算量同时也限制了这个领域的进一步发展,对那些计算资源不足的研究者十分不友好。例如,训练一个 243 帧的 VPT 模型通常需要花费好几天的时间,严重拖慢了研究的进度,并成为了该领域亟待解决的一大痛点。

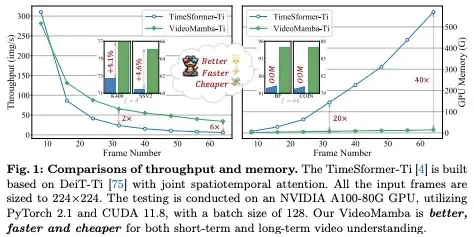

视频理解因大量时空冗余和复杂时空依赖,同时克服两个问题难度巨大,CNN 和 Transformer 及 Uniformer 都难以胜任,Mamba 是个好思路,让我们看看本文是如何创造视频理解的 VideoMamba。

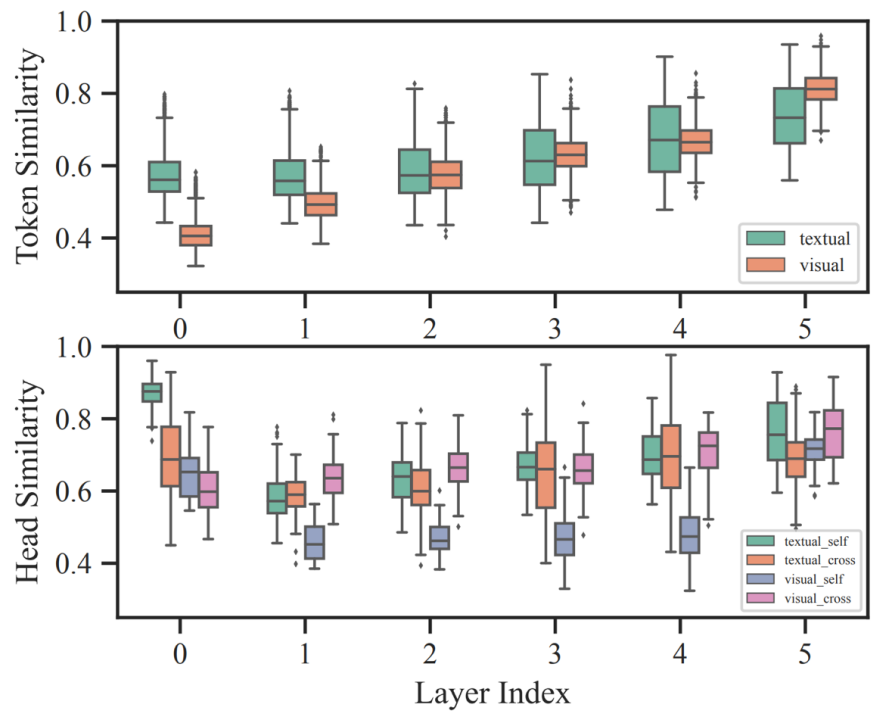

哈工大联合度小满推出针对多模态模型的自适应剪枝算法 SmartTrim,论文已被自然语言处理顶级会议 COLING 24 接收。

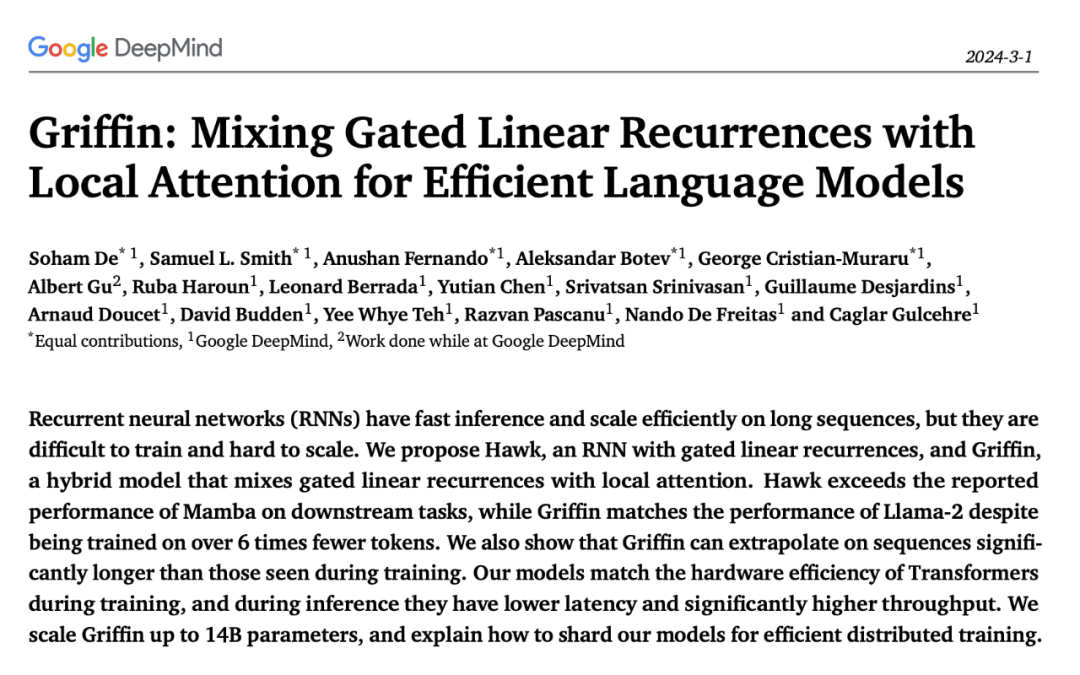

去年 12 月,新架构 Mamba 引爆了 AI 圈,向屹立不倒的 Transformer 发起了挑战。如今,谷歌 DeepMind「Hawk 」和「Griffin 」的推出为 AI 圈提供了新的选择。

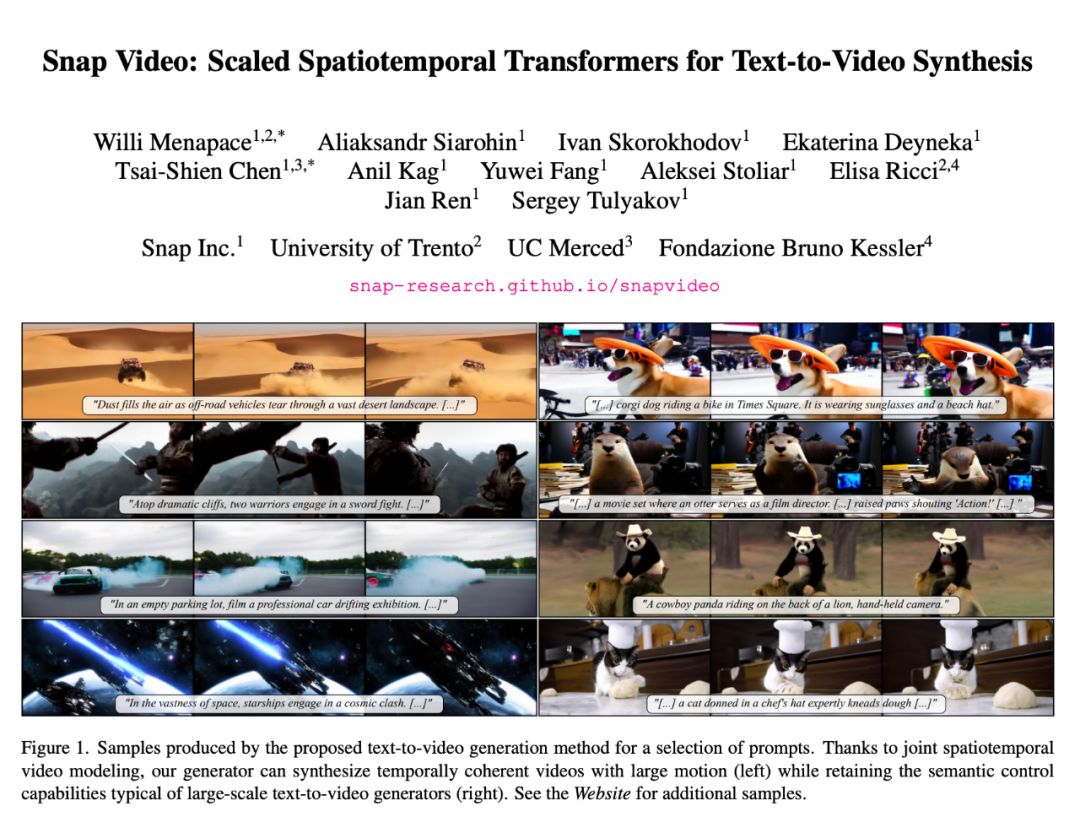

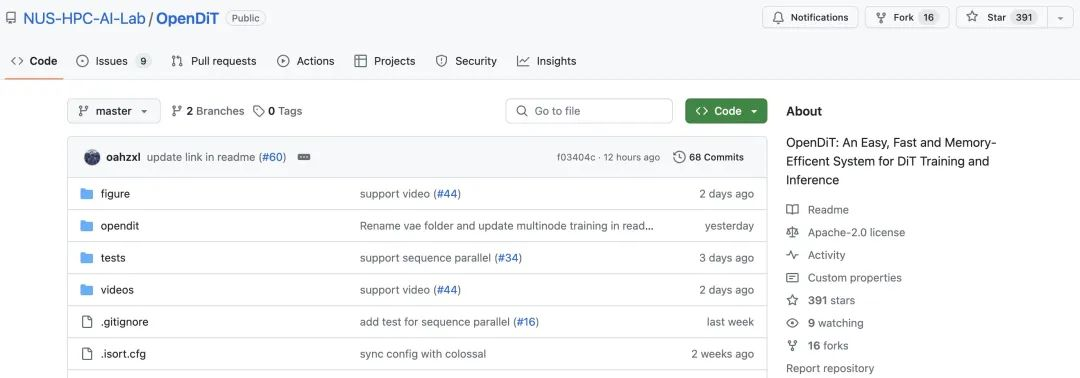

最近,OpenAI 视频生成模型 Sora 的爆火,给基于 Transformer 的扩散模型重新带来了一波热度,比如 Sora 研发负责人之一 William Peebles 与纽约大学助理教授谢赛宁去年提出的 DiT(Diffusion Transformer)。

根据 OpenAI 披露的技术报告,Sora 的核心技术点之一是将视觉数据转化为 patch 的统一表征形式,并通过 Transformer 和扩散模型结合,展现了卓越的扩展(scale)特性。

近期,DiT(Diffusion Transformer)论文的作者谢赛宁在朋友圈分享了他对 Sora 的看法,其中核心资源的排序是——人才第一、数据第二、算力第三,其他都没有什么是不可替代的。

2 月 16 日,OpenAI Sora 的发布无疑标志着视频生成领域的一次重大突破。Sora 基于 Diffusion Transformer 架构,和市面上大部分主流方法(由 2D Stable Diffusion 扩展)并不相同。

最近几年,基于 Transformer 的架构在多种任务上都表现卓越,吸引了世界的瞩目。使用这类架构搭配大量数据,得到的大型语言模型(LLM)等模型可以很好地泛化用于真实世界用例。